Psicología

¿La apariencia de un robot afecta a cómo juzgamos la ética de sus actos?

Los robots son cada vez más inteligentes y pueden llegar a tomar decisiones éticamente complejas, como por ejemplo la de a quién salvarle la vida y a quién dejar morir, ante la imposibilidad de salvar a ambas personas durante una operación de rescate. Un nuevo estudio ha explorado las reacciones psicológicas que puede experimentar la gente ante acciones como la del ejemplo realizadas por robots de varios tipos.

Un equipo internacional que incluye a Michael Laakasuo y Jussi Palomäki, de la Universidad de Helsinki en Finlandia, investiga la actitud de las personas ante las decisiones morales tomadas por sistemas de inteligencia artificial. En el último estudio en esta línea de investigación, los sujetos de estudio leyeron relatos breves en los cuales un robot con apariencia rudimentariamente humanoide, o un robot con aspecto bastante humano llamado “iRobot”, o un robot con una gran apariencia humana llamado “iClooney, o un ser humano, se topan con un dilema moral en una situación en la que deben decidir quién vive y quién muere. A los participantes también se les mostraron imágenes de esos robots y del humano, en concordancia con los relatos que habían leído, y después debían evaluar el grado de ética de las decisiones tomadas.

La situación hipotética expuesta a los sujetos de estudio era que un individuo ve cómo un tranvía se mueve, sin que nadie lo controle, hacia cinco personas. El individuo (el humano o uno de los tres robots) puede no hacer nada o desviar el tranvía hacia otra vía, salvando a las cinco personas pero atropellando y matando a otro individuo en la otra vía. Las decisiones de este tipo, que implican matar activamente en vez de tan solo dejar morir despiertan mucha aversión en el Ser Humano a la hora de tomarlas y generan sentimientos contradictorios a la hora de juzgar una decisión de ese tipo tomada por otro. Por regla general, en estos casos se considera que es mejor la decisión que salva la mayor cantidad de vidas, aunque tomarla se considere poco empático e incluso despiadado.

Los resultados del estudio revelaron que los participantes consideraban que la decisión tomada por el robot iRobot y por el iClooney era menos sólida desde el punto de vista ético que la misma decisión tomada por el individuo humano y por el robot con apariencia de robot tradicional (muy poco humana). Laakasuo cree que este extraño resultado se debe al fenómeno psicológico conocido como "Valle Extraño", cuya existencia ya ha sido verificada en estudios anteriores.

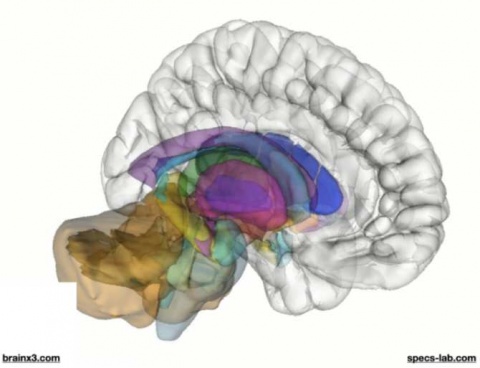

![[Img #63340]](https://noticiasdelaciencia.com/upload/images/03_2021/336_la-apariencia-de-un-robot-afecta-a-como-juzgamos-la-etica-de-sus-actos.jpg)

Ejemplo de robot con una apariencia “tradicional”, solo someramente humanoide, el Robonaut 2 de la NASA. (Foto: NASA)

La teoría del Valle Extraño, propuesta en 1970 por el pionero de la robótica Masahiro Mori, sugiere, entre otras cosas, que cuanto más se parezca un robot a un ser humano, más positivamente reaccionará ante él un humano, pero solo hasta cierto punto. Cuando el parecido es muy grande, pero no hasta el punto de que el observador crea estar ante un humano real y por tanto no se entere de que está ante un robot, se produce una sensación de repulsión o aprensión hacia el androide. Por supuesto, descubrir que alguien a quien considerábamos un humano es en realidad un robot, también puede provocarnos sensaciones de miedo y rechazo.

"La condición humana en la inteligencia artificial se percibe como algo inquietante o espeluznante, y las actitudes hacia esos robots son más negativas que hacia los robots con más aspecto de máquina", reitera Laakasuo.

Los resultados del estudio indican que los humanos no consideramos una situación inaceptable que los robots tomen decisiones morales, ya que los sujetos de estudio consideraron la decisión tomada por el robot tradicional tan aceptable como la tomada por el humano. En cambio, la apariencia física del robot, concretamente su parecido a un humano, marca la diferencia a la hora de evaluar su moralidad.

La cuestión es importante, ya que la cantidad de máquinas inteligentes que toman decisiones morales está creciendo en nuestra sociedad, con los coches autoconducidos en una situación de accidente inminente como ejemplo claro. (Fuente: NCYT de Amazings)