Computación y cosmología

Ejecutan la simulación más grande de la evolución del universo

Unos astrónomos han llevado a cabo la mayor simulación informática realizada hasta ahora de la evolución del universo, que abarca desde el Big Bang hasta nuestros días, destinada a investigar cómo ha evolucionado el universo.

A través de diversas sesiones, la simulación FLAMINGO calcula la evolución de todos los componentes del universo, incluyendo materia ordinaria, neutrinos, materia oscura y energía oscura, basándose en las leyes conocidas de la física. A medida que avanza cada versión de cada etapa de la simulación, surgen en ella galaxias y cúmulos de galaxias con todo lujo de detalles.

El equipo de FLAMINGO lo integran científicos de la Universidad John Moores de Liverpool, la de Durham y la de Leiden, las dos primeras en el Reino Unido y la tercera en los Países Bajos.

Estos científicos confían en que la simulación permita comparar el universo virtual con observaciones del real captadas por nuevos telescopios de alta potencia, como el telescopio espacial James Webb.

Esto podría ayudar a discernir si el modelo estándar de la cosmología, utilizado para explicar la evolución del universo, proporciona una buena descripción de la realidad.

Los primeros estudios basados en FLAMINGO han sido publicados recientemente en la revista académica Monthly Notices of the Royal Astronomical Society.

![[Img #70232]](https://noticiasdelaciencia.com/upload/images/10_2023/6126_ejecutan-la-simulacion-mas-grande.jpg)

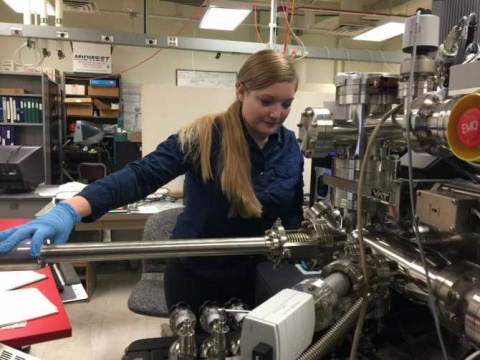

Una proyección a través de una rebanada de 130 millones de años-luz de espesor, en una sesión de simulación centrada en un volumen cúbico de 9.132 millones de años-luz de lado. (Imagen: Josh Borrow / FLAMINGO team / Virgo Consortium. CC BY)

Las sesiones de simulación de FLAMINGO se han estado ejecutando durante los dos últimos años en la supercomputadora COSMA 8 (Cosmology Machine 8), alojada en el Instituto de Cosmología Computerizada de la Universidad de Durham. Las sesiones han consumido un total de más de 50 millones de horas de procesador.

Para hacer posible FLAMINGO, los investigadores desarrollaron un nuevo código informático, denominado SWIFT, que distribuye eficazmente el trabajo computacional entre miles de unidades centrales de procesamiento (CPUs), a veces hasta 65.000.

La gran cantidad de datos (virtuales) creados por las sesiones de simulación ofrece oportunidades para hacer nuevos descubrimientos teóricos y probar nuevas técnicas de análisis de datos, entre ellas el aprendizaje automático (una modalidad de inteligencia artificial).

Durante las sesiones de simulación, el equipo, integrado, entre otros, por Roi Kugel de la Universidad de Leiden y Carlos Frenk, del Instituto de Cosmología Computacional de la Universidad de Durham, ha usado diferentes resoluciones y también versiones distintas de otros factores como la fuerza de los vientos galácticos y la masa de los neutrinos. (Fuente: NCYT de Amazings)